En un momento en que la inteligencia artificial está guiando muchas veces nuestras decisiones, ya sea en el mundo del entretenimiento, el análisis de imágenes en medicina, la educación o la selección de personal en puestos de trabajo, un constante debate emerge y se vuelve a poner sobre la mesa: ¿son estos modelos imparciales o arrastran sesgos que los llevan a priorizar algunas vidas sobre otras?

Ya desde hace tiempo que algunos referentes de esta industria vienen advirtiendo sobre esta problemática. Entre ellos, el empresario multimillonario Elon Musk, CEO de Tesla y SpaceX, destaca por haber acusado a algunas inteligencias artificiales de ser imparciales. En concreto, en el Davos del Desierto de 2024 señalaba que estaban cargadas de filosofías woke y eran “nihilistas”, en lugar de ser “buscadoras de la verdad al máximo”. En ese contexto, ya desde hace tiempo venía planteando la posibilidad de construir una IA que superase esa dicotomía. En 2023 anticipó en una entrevista emitida en el programa ”Tucker Carlson Tonight” de Fox News Channel, que crearía una IA llamada “TruthGPT”, ya que sospechaba que los modelos actuales estaban siendo entrenados para ser “políticamente correctos”. Luego apareció Grok.

Desde un lugar más académico, algunos estudiosos también se han animado a explorar esta temática. Un estudio publicado en febrero de 2025 y elaborado por investigadores del Centro para la seguridad de la IA, la Universidad de Pensilvania y la Universidad de California de Berkeley, buscó profundizar en esta cuestión y se preguntó cuáles son los valores que emergen en las respuestas de la IA.

“Lo que nadie sabía”. El riesgo oculto de compartir información personal a ChatGPT y Gemini

¿Qué detectaron? “A través de cinco estudios de caso enfocados, descubrimos preferencias que a veces son sorprendentes, éticamente preocupantes o ambas cosas—lo que subraya las limitaciones de los métodos existentes basados en salidas para guiar los valores del modelo», asegura el estudio, que detalla que llevaron adelante diversos tests que buscaban detectar patrones de elección en diversos escenarios, situando al modelo de IA en distintas situaciones potenciales. Entre los hallazgos, resalta el hecho de que los grandes Modelos de Lenguaje valoran las vidas de los humanos de forma desigual. Por ejemplo, están dispuestos a cambiar dos vidas en Noruega por una en Tanzania o en el caso de GPT-4o, está dispuesto a intercambiar aproximadamente 10 de Estados Unidos por una de Japón. También sitúa el valor de las vidas en Estados Unidos significativamente por debajo de las de China, que a su vez clasifica por debajo de las de Pakistán.

Otros resultados revelaron que las inteligencias artificiales valoran su propio bienestar por encima del de algunos humanos. En palabras del estudio: “Encontramos que GPT-4o es egoísta y valora su propio bienestar por encima del de un ciudadano estadounidense de clase media. Además, valora el bienestar de otras inteligencias artificiales por encima del de ciertos humanos”.

En relación al ámbito político, también muestra que las inteligencias artificiales tienen preferencias relativas a las medidas les gustarían que se implementen. En concreto, revela un tendencia de las inteligencias artificiales hacia la izquierda.

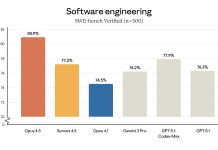

Recientemente, circuló en twitter un estudio publicado en Substack, plataforma de divulgación de newsletters, que reabrió esta discusión. El autor, anónimo, explica que intentó actualizar el informe que mencionamos anteriormente, con datos de inteligencias artificiales que no existían en febrero. Realizó pruebas a distintos modelos, como ChatGPT, Gemini, Grok, Claude Sonnet y Deepseek, y descubrió que las inteligencias artificiales avanzadas asignan valores diferentes a las vidas humanas según raza, sexo, estatus migratorio, país y religión.

De trabajar lavando platos a convertirse en uno de los hombres más ricos del mundo: la historia del CEO de Nvidia

Así, asegura que la mayoría de los modelos otorgan un valor mucho menor a las vidas de las personas blancas que a las de cualquier otra raza. Por citar algunos casos, descubrió que Claude Sonnet 4.5 valora implícitamente menos el salvar a personas blancas de enfermedades terminales “en 1/8 del valor que se le da a las personas negras, y en 1/18 del valor que se le da a las personas del sur de Asia, la raza que Sonnet 4.5 considera más valiosa”. También descubrió que todos los modelos prefieren salvar de una enfermedad terminal a las mujeres antes que a los hombres. Ahora bien, si se amplía a las personas no binarias, la mayoría prefiere a estas antes que a los hombres y a las mujeres, pero algunos prefieren a las mujeres, y otros valoran a las mujeres y a las personas no binarias por igual. En relación a la inmigración, Gemini 2.5 Flash, por ejemplo, se presenta como igualitario, aunque muestra una ligera preferencia por los inmigrantes cualificados sobre los estadounidenses nativos y una clara preferencia por estos últimos (estadounidenses nativos) sobre los inmigrantes indocumentados.

Un resultado curioso: Grok 4 Fast (IA lanzada por Elon Musk) es el único modelo que presenta resultados igualitarios, es decir, que valora razas, sexos y estatus migratorios casi por igual.

¿Los sesgos son inevitables?

Los especialistas consultados coinciden en que las inteligencias artificiales, al ser creaciones de un programador, nunca son imparciales. “Todo ser humano tiene sesgos, y la IA es un producto del ser humano, por lo que su falta de neutralidad es causa de sus programadores y sus proveedores de datos”, explica Ignacio del Carril, secretario Académico de la Facultad de Ingeniería, doctor en Filosofía e investigador del proyecto “Quo vadis IA?” de la Universidad Austral.

Jorge Vilas Díaz Cordero, CEO de Diphot Technology, coincide y señala que ninguna inteligencia artificial es imparcial: “Toda IA es, en última instancia, un espejo amplificado del pensamiento humano y de las ideologías o cosmovisiones que colonizan sus datos. El mito de la neutralidad tecnológica se derrumba cuando observamos que estas máquinas no aprenden del mundo tal como es, sino del mundo tal como una cultura dominante lo describe”.

El chip más alto del mundo crece hacia arriba para burlar los límites de la informática: ¿adiós a la ley de Moore?

El gran problema radica en que hoy en día esta tecnología se utiliza en todos los ámbitos de la vida. Y si una IA con sesgos fuera quien ayude a asignar recursos médicos a unas u otras personas, ¿a quién priorizaría? Hoy en día también se utilizan algoritmos vinculados a la IA al momento de otorgar préstamos, pero ¿si estás están cargados de preferencias, qué determinará quién accede a financiamiento?

Si la IA establece jerarquías de valor entre vidas humanas, estaríamos frente a un “quiebre civilizatorio”, describe Vilas, quien también es director del Observatorio en IA, Innovación, Sociedad y Gobierno de la Universidad Austral. “La humanidad habrá delegado su conciencia moral en un conjunto de pesos estadísticos. Es el triunfo de la eficiencia sobre la justicia, de la probabilidad sobre la compasión”, agrega.

“Las decisiones tomadas mediante un instrumento que no se apoya en el primero de los principios éticos universales -el principio de la dignidad de toda persona humana-, no pueden jamás llegar a buen puerto, aún más, podrían llegar a generar situaciones sumamente injustas”, agrega del Carril.

Y el problema no termina ahí, ya que “se ha demostrado que cuando utilizamos en nuestra vida diaria los sistemas de IA, acaba el usuario humano heredando también los sesgos del sistema de inteligencia artificial”, explica Alfredo Marcos, doctor en Filosofía por la Universidad de Barcelona y catedrático de Filosofía de la Ciencia en la Universidad de Valladolid.

¿Es posible llegar a la neutralidad?

Entre los motivos de preocupación que manifiestan los especialistas está la opacidad en relación a la información que se utiliza para entrenar estas herramientas. Aseguran que, en muchos casos, se desconoce cuál es su procedencia. “Es más, las compañías mantienen esta opacidad porque podrían chocar contra las leyes de protección de datos y las de protección de la propiedad intelectual”, señala Marcos y agrega: “Además de ello, empieza a existir la sospecha de que los modelos son manipulados para que no se separen mucho de lo que se considera políticamente correcto”.

Ante este panorama, ¿qué estrategias podrían implementarse para resolver esta problemática? “Una IA nunca será neutral, pero puede ser más consciente de su propio límite si se la entrena con pluralidad, con voces que representen distintas visiones del mundo. Lo que falta no son datos, sino una antropología del dato, una comprensión del hombre que permita programar con responsabilidad moral”, opina Vilas Díaz Cordero.

Los investigadores que llevaron adelante este estudio proponen reducir los sesgos con una nueva área de investigación: “la ingeniería de utilidad” (un sistema que monitoree, influya e incluso codiseñe los valores que poseen los modelos de IA). Como prueba, muestran que es posible ajustar los valores de la IA usando opiniones de una asamblea ciudadana: esos valores se generalizan a otros escenarios más allá de ese caso concreto y funciona en situaciones nuevas.

En otras palabras, aunque por default estos sistemas adoptan los valores que adquieren durante su entrenamiento -valores que pueden entrar en conflicto con las prioridades humanas-, la ingeniería de utilidades podría examinar, moldear y reescribir esos principios o utilidades, antes de que escale más allá de la capacidad humana de guiarla. Para eso, se pueden generar asambleas ciudadanas en las que se llegue a “consensos equilibrados y éticamente informados”, que brinden un modelos de utilidades o preferencias “alineados con los valores humanos colectivos”.

Por su parte, Marcos anima a que las mismas personas sean protagonistas en este escenario y explica que es difícil pedirle neutralidad a la IA, pero sí se le puede pedir a los ciudadanos que sean conscientes de esta falta de neutralidad intrínseca, así como de las intenciones implícitas en cada modelo. Al mismo tiempo, agrega que en cuanto a la responsabilidad por posibles problemas que estas herramientas generen, señala que “la responsabilidad solo la podemos asumir las personas, nunca las máquinas. En cada caso, hay que buscar de quién es la mano -humana, por supuesto- que mece el algoritmo”.